免责声明:所有内容均转载自网络或是使用经验,仅供参考,解压及网盘密码 1024

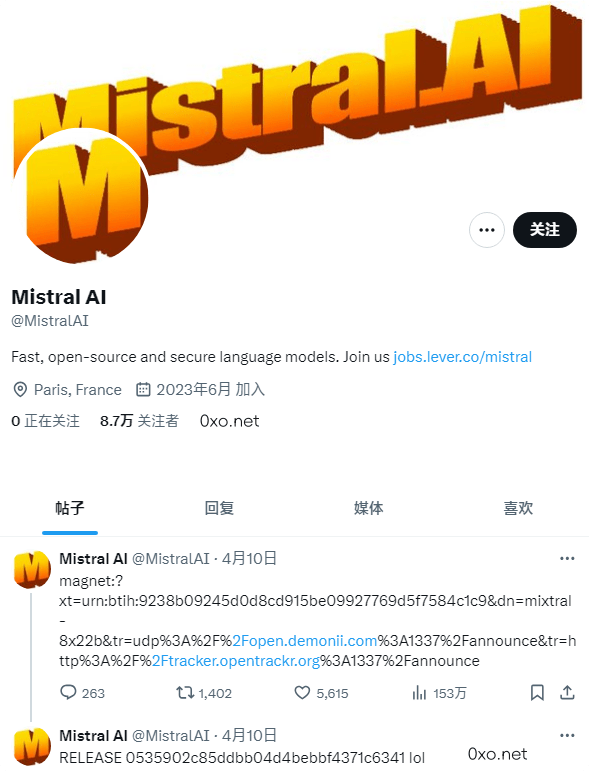

Mistral AI 公司近日推出了 Mixtral 8x22B 开源模型,由 8 个 220 亿参数规模 (8×22B) 的专家网络组成,Context 长度(上下文文本)为 6.5 万个 token,可以通过 BT 磁力下载。

「Mistral AI 开源 Mixtral 8x22B 模型281GB可BT下载:https://0xo.net/803」从模型的名字来看,Mistral 8x22B 是去年开源的「mixtral-8x7b」的超级大杯版本,参数规模增长三倍不止,模型文件大小为 281.24 GB 。

Mixtral 8x22B 共有 1760 亿个参数,Context 长度(上下文文本)为 6.5 万个 token,不过为单一任务可以调用部分模型(440 亿参数),使用更加灵活。

帖子:https://twitter.com/MistralAI/status/1777869263778291896

「Mistral AI 开源 Mixtral 8x22B 模型281GB可BT下载:https://0xo.net/803」Mixtral 8x22B 磁力下载地址:

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce

任何服务均有跑路风险,请注意甄别防范!!备用节点参考:大哥云、万城v-city、飞机云、搬瓦工JMS、极客云……解压及网盘密码 1024